0Gの分散AIオペレーティングシステムは、スケールでAIをオンチェーンに本当に推進できるか?

2024年11月13日、0G LabsはHack VC、Delphi Digital、OKX Ventures、Samsung Next、Animoca Brandsが主導する4000万ドルの資金調達ラウンドを発表し、分散AIオペレーティングシステムの開発チームが注目を浴びました。モジュラーアプローチで分散ストレージ、データ可用性検証、分散決済を組み合わせ、オンチェーンでAIアプリケーションを実現します。しかし、GB/秒レベルのスループットを実現し、Web3上で次世代AI採用を加速できるでしょうか?本稿では、0Gのアーキテクチャ、インセンティブ設計、エコシステムの動向、潜在的リスクを徹底評価し、0Gが約束を実現できるかを検証します。

背景

AI分野は、ChatGPTやERNIE Botといった大規模言語モデルに牽引され、急速に拡大しています。AIはチャットボットや生成テキストに留まらず、AlphaGoの囲碁勝利やMidJourneyの画像生成など多岐にわたります。多くの開発者が目指す究極の目標は、AGI(汎用人工知能)、すなわち人間に近い学習・認知・意思決定・実行能力を持つAI「エージェント」です。

しかし、AIおよびAIエージェントはデータ集約型であり、膨大なデータセットがトレーニング・推論に必要です。従来は集中型インフラでデータを保管・処理してきましたが、ブロックチェーンの登場により**DeAI(分散AI)**という新概念が生まれました。DeAIは分散ネットワークを��活用し、データの保存・共有・検証を行うことで、集中型AIの課題を克服しようとします。

0G LabsはこのDeAIインフラ領域で際立った存在であり、**「0G」**という分散AIオペレーティングシステムの構築を目指しています。

0G Labsとは?

従来のコンピュータでは、**OS(オペレーティングシステム)**がハードウェアとソフトウェア資源を管理し、ユーザーや開発者が容易に利用できるよう抽象化します(例:Windows、Linux、macOS、iOS、Android)。

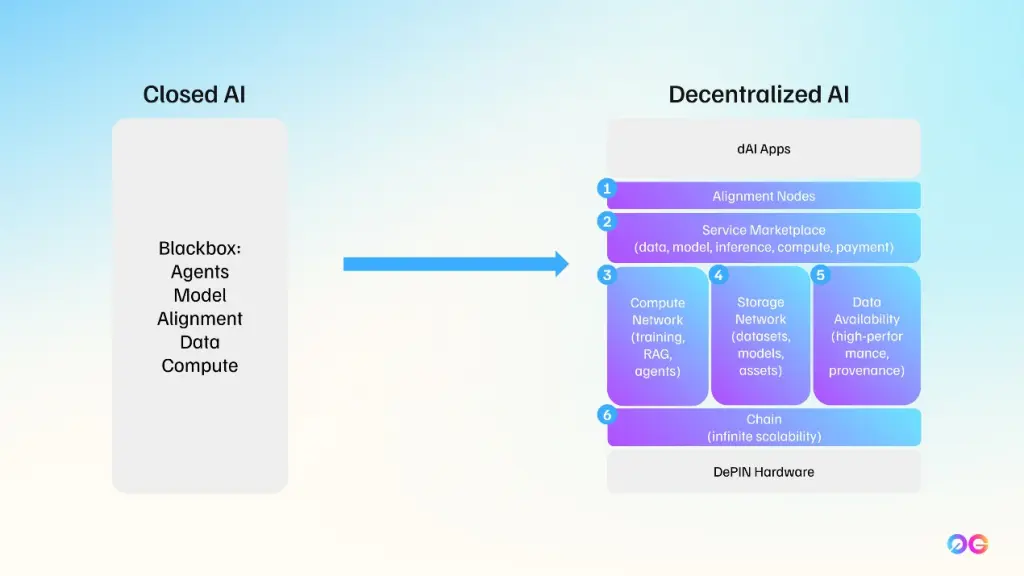

0G OSはWeb3における同様の役割を担うことを目指しています:

- 分散ストレージ、計算、データ可用性を管理する

- オンチェーンAIアプリケーションのデプロイを簡素化する

なぜ分散化か? 従来のAIシステムはデータを集中型サイロに保存・処理し、透明性・プライバシー・データ提供者への公正な報酬といった課題があります。0Gは分散ストレージ、暗号証明、オープンインセンティブモデルを組み合わせ、これらのリスクを低減します。

**「0G」**は “Zero Gravity(無重力)” の略で、データ交換や計算が「重さを感じない」環境をイメージしています。2024年10月に正式設立された 0G Foundation は、AIを「公共財」として、誰でもアクセス・検証・利用できる状態にすることをミ��ッションとしています。

0Gオペレーティングシステムの主要コンポーネント

0GはAIアプリケーション向けに設計されたモジュラーアーキテクチャで、3つの柱から構成されます:

- 0G Storage – 分散ストレージネットワーク

- 0G DA(Data Availability) – データ可用性レイヤー

- 0G Compute Network – 分散計算リソース管理・決済レイヤー

これらは 0G Chain と呼ばれる Layer1 ネットワークの下で連携し、コンセンサスと決済を担います。

0G Whitepaper(「0G: Towards Data Availability 2.0」)によれば、0G Storage と 0G DA は 0G Chain 上に構築され、開発者はカスタム PoS コンセンサスネットワーク を複数立ち上げて、DA と Storage のフレームワークとして利用できます。システム負荷が増大すれば、バリデータセットや専用ノードを動的に追加して水平スケーリングが可能です。

0G Storage

0G Storage は大規模データ向けの分散�ストレージシステムで、インセンティブ付きノードがユーザーデータを保管します。データは Erasure Coding(EC) によって 小さな冗長「チャンク」 に分割され、複数ノードに分散保存されます。ノードが故障しても、冗長チャンクからデータ復元が可能です。

サポートされるデータタイプ

0G Storage は 構造化データ と 非構造化データ の両方に対応します。

- 構造化データ は Key-Value(KV)レイヤー に格納され、データベースや共同編集ドキュメントなど頻繁に更新される情報に適しています。

- 非構造化データ は Log レイヤー に格納され、時系列でデータを追記していく方式です。大規模なファイルやモデルウェイトの保存に最適です。

KV レイヤーを Log レイヤー上に積むことで、モデルウェイト(非構造化)からリアルタイムメトリクスやユーザー設定(構造化)まで、幅広いAIユースケースに対応できます。

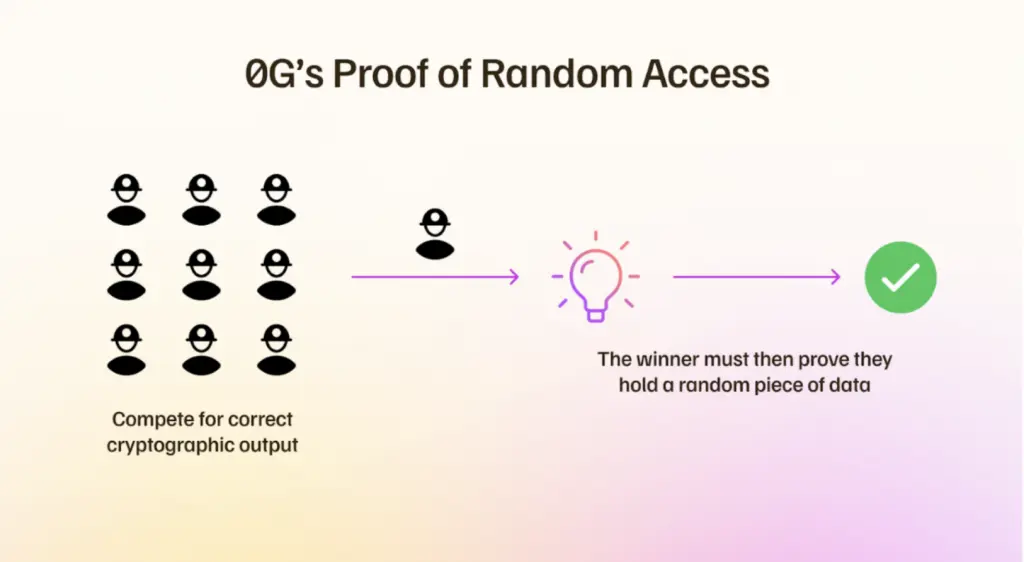

PoRA コンセンサス

PoRA(Proof of Random Access) はストレージノードが実際にチャンクを保持していることを証明しま�す。

- ストレージマイナーは定期的に ランダムに選ばれたチャンク のハッシュ計算を要求されます。

- 正しいハッシュを返すことで、PoW に似た暗号的証明を提供します。

公平性を保つため、マイニング競争は 8 TB セグメント に限定されます。大規模マイナーはハードウェアを複数の 8 TB パーティションに分割し、小規模マイナーは単一の 8 TB 境界内で競争します。

インセンティブ設計

データは 8 GB の「Pricing Segment」 に分割され、各セグメントに 寄付プール と 報酬プール が用意されます。ユーザーは ZG(0G Token) でストレージ料金を支払い、その一部がノード報酬に回ります。

- ベース報酬:ノードが有効な PoRA 証明を提出すると、即座にブロック報酬が支払われます。

- 継続報酬:寄付プールの一部(現在は年率 4 %)が報酬プールへ移行し、永続的な保存 をインセンティブ化します。保存ノードが少ないほど、各ノードのシェアは大きくなります。

ユーザーは 一度だけ 永続保存料を支払えばよく、システムが定める最低寄付額以上を設定すれば、マイナーがデータを複製しやすくなります。

ロイヤリテ�ィ機構:0G Storage では「ロイヤリティレコード」を作成し、他ノードが同じチャンクを保存する際に元ノードがデータを共有できます。新ノードが PoRA 証明を行うたびに、元データ提供者に継続的ロイヤリティが支払われます。データが広く複製されるほど、初期提供者の総報酬は増加します。

Filecoin・Arweave との比較

類似点

- いずれも分散データ保存をインセンティブ化

- 永続保存を目指す点(Arweave と 0G Storage)

相違点

- ネイティブ統合:0G Storage は独立ブロックチェーンではなく 0G Chain に直接組み込まれ、AIユースケースに特化。

- 構造化データ:KV レイヤーにより頻繁な読み書きが可能。

- コスト:永続保存費用は $10–11/TB とされ、Arweave より安価。

- パフォーマンス志向:AI スループット向けに最適化されており、Filecoin/Arweave は汎用的。

0G DA(Data Availability Layer)

データ可用性は、ネットワーク参加者全員がトランザクションデータを完全に検証・取得できることを保証します。データが欠損または隠蔽され��ると、ブロックチェーンの信頼前提が崩れます。

0G ではデータを オフチェーンでチャンク化 し、Merkle ルートをチェーン上に記録します。DA ノードは サンプリング によりチャンクが Merkle ルートと EC コミットメントに一致するか検証し、合格すれば可用性が確保されたとみなします。

ノード選択とコンセンサス

- 画像パラメータ:

?title=に URL エンコードされたタイトルが渡されます。 - バリデータ:PoS に基づくカスタムコンセンサスネットワークを複数立ち上げ、各ネットワークが独自の DA プロトコルを実装可能。

- 水平スケーリング:負荷増大時に追加 DA ノードを投入し、サンプリング頻度と検証精度を維持します。

0G Compute Network

0G Compute は オンチェーンで計算リソースを予約・決済 できる分散コンピューティングレイヤーです。主な機能は以下の通りです:

- 計算リソースのマーケットプレイス:インセンティブ付きノードが CPU / GPU 時間を提供。

- 決済インフラ:0G Storage と同様に ZG で報酬・手数料を支払う仕組み。

- プライバシー保護:計算結果は暗号化されたままチェーンに記録可能(将来的な zk‑Rollup との統合を想定)。

0G の技術的ハイライト

- モジュラー設計:Storage、DA、Compute が独立かつ相互参照可能。

- PoRA + PoS:データ保存とコンセンサスを分離し、スループット向上を実現。

- 永続保存とロイヤリティ:データの長期保存と提供者報酬を自動的に循環。

- EVM 互換性:0G Chain は EVM に対応し、既存のスマートコントラクトとシームレスに統合可能。

- 高スループット志向:Erasure Coding と水平スケーリングにより、AI 推論の大量リクエストを処理できる見込み。

エコシステムとユースケース

0G は現在、以下の領域でパートナーシップを拡大中です:

- 分散AIモデルホスティング:大規模言語モデルやマルチモーダルモデルの永続保存。

- オンチェーンデータマーケット:データ提供者が ZG で報酬を受け取るデータ販売プラットフォーム。

- プライバシー保護推論:ゼロ知識証明と組み合わせた機密推論サービス。

- DAO 主導の AI ガバナンス:0G のインセンティブメカニズムを利用した DAO がモデル更新やパラメータ調整を投票で決定。

リスクと課題

| 項目 | 説明 |

|---|---|

| 技術的成熟度 | PoRA、EC、サンプリングは理論上は有効だが、実装規模が大きくなるとネットワーク遅延や証明生成コストが増大する可能性。 |

| トークンエコノミクス | ZG の価格変動がインセンティブの安定性に直結。市場価格が下落した場合、永続保存料が不足するリスク。 |

| 規制リスク | 分散ストレージと AI データの組み合わせは、データプライバシー法(GDPR、個人情報保護法)との整合性が求められる。 |

| 競合 | Filecoin、Arweave、IPFS、Ocean Protocol など既存分散ストレージ・データマーケットが成熟しつつある。差別化が持続できるかが鍵。 |

| ユーザー体験 | 日本語を含む多言語 UI の整備や、開発者向け SDK の充実が遅れると、採用が進まない恐れ。 |

結論と今後の展望

0G は AI スループット と データ可用性 を同時に解決しようとする、非常に野心的かつ技術的に高度なプロジェクトです。PoRA による永続保存ロイヤリティや、KV/Log の二層ストレージ設計は、AI モデルとリアルタイムデータのハイブリッド保存に適しています。一方で、GB/秒規模のスループットを実現するためには、バリデータ・ストレージノードの大規模な水平展開と、ネットワーク遅延の最適化が不可欠です。

現時点では、資金調達により 4000万ドル の開発リソースが確保され、プロトタイプの実装が進行中です。エコシステムパートナーシップ(例:DeFi プロトコル、AI スタートアップ)も拡大しており、Web3 上での AI 高スループット が実現すれば、分散AI市場のリーダーシップを獲得できる可能性があります。

次のステップ としては、以下が重要です:

- ベンチマークテスト:実際のモデル推論ワークロードで GB/秒レベルのスループットを測定。

- インセンティブチューニング:寄付率・ロイヤリティ率を市場状況に合わせて動的に調整。

- 開発者向け SDK のリリース:0G OS の API を標準化し、簡単にオンチェーン AI アプリを構築できる環境を提供。

- 規制対応:データプライバシーとトークンエコノミクスの法的枠組みを明確化。

総合的に見て、0G は 分散AIインフラの先駆者 としてのポテンシャルを有していますが、スケーラビリティとエコシステム成熟度が鍵となります。今後の技術実装と市場受容の動向を注視すべきでしょう。